技術系はNoteのブログに移行しました

https://note.com/green_blue_sky/m/m45b1f2fbfbde

相対性理論は、20世紀初頭にアインシュタインによって提案され、数々の実験的な検証を経て成功を収めた、非常に成功した物理学の理論です。しかし、その一部には未解決の問題や課題が存在します。以下に、相対性理論に関連する主要な問題点や課題をいくつか示します。

相対性理論は、宇宙全体の構造や進化を説明するために広く受け入れられていますが、宇宙の約95%が暗黒物質と暗黒エネルギーで構成されているとされ、これらの物質やエネルギーの正体は未だに解明されていません。相対性理論ではこれらを説明できないため、新しい理論が必要かもしれません。

一般相対性理論によれば、ブラックホールの中心には「特異点」と呼ばれる物理的な無限が存在するとされています。この特異点についての理論的な説明は未だに確立されておらず、物理学者たちはこの問題に対処するための理論を模索しています。

相対性理論では、情報や物体は光速度以上で移動することはできないとされています。しかし、一部の理論や実験結果が、超光速粒子やタキオンといったものの存在を示唆しており、これらの粒子の振る舞いを説明する新たな理論の必要性があります。

これらは相対性理論の一部の課題や未解決の問題ですが、相対性理論は依然として物理学の基盤として非常に有用で、多くの実験的な検証に合格しています。将来の研究によって、これらの課題に対する新たな理論やアプローチが発展することでしょう。

【具体的な相談内容】

Python+FastAPI+UvicornでのAPIサーバーのレスポンスが良くなく、Uvicornやその他サーバー設定の変更により改善できないかサポートいただきたいです。

Python+FastAPI+Uvicornの経験のある方にお願いできますと幸いです。

【現在の設定やアクセス状況など】

下記のコマンドでuvicornを立ち上げています。

nohup uvicorn main:app --port=80 --host=0.0.0.0 --workers=9

(ネットでworkersの数値はコア数×2+1が適正という情報を見かけたのでそのようにしています)

APIリクエストは別サーバーのバッチ処理からのみなので、同時リクエストは常時8以下程度になるようコントロールしているのですが、遅い時にはAPIレスポンスに30秒ほどがかかっています。

同じ処理内容のpyファイルを実行すると毎回1秒前後でレスポンスが返ってくるので、uvicornもしくはサーバー側の設定に問題があるものと考えています。

【サーバー環境】

エックスサーバーVPS(vCPU4コア・メモリ4GB)

OS:Ubuntu 20.04

Python 3.8.10

FastAPIとUvicornを使用したAPIサーバーのレスポンスが遅い問題を解決するためのアドバイスを提供します。以下のステップを試してみてください。

--workersフラグを調整することは、サーバーのパフォーマンスに影響を与えることがあります。一般的なガイドラインは、コア数×2+1ですが、この値はサーバーのスペックや負荷によって異なります。試しにワーカーの数を増減させて、最適な設定を見つけてみてください。たとえば、もし4コアのCPUを持っている場合、ワーカーの数を9から8に減らすことも考えられます。

nohup uvicorn main:app --port=80 --host=0.0.0.0 --workers=8

UvicornはASGIサーバーの一つですが、他にも多くのASGIサーバーがあります。一部のプロジェクトでは、Uvicornよりも性能が良いとされるサーバーもあります。代替のASGIサーバーを試してみることを検討してください。例えば、HypercornやDaphneを試すことができます。

FastAPIとUvicornは非同期処理に対応しており、遅いレスポンスの原因が非同期処理の最適化にあるかもしれません。コード内で非同期処理を効果的に利用しているか確認し、遅延を引き起こす部分を最適化してみてください。

レスポンスが遅い場合、どの部分が遅いのかを特定するためにリクエスト処理をプロファイリングすることが役立つことがあります。PythonのcProfileモジュールやプロファイリングツールを使用して、処理時間のかかる部分を特定し、最適化の手がかりを得ることができます。

サーバーのリソース使用状況(CPU、メモリ、ディスクIOなど)を監視し、問題がリソース不足に起因している可能性を確認してください。リソースが不足している場合は、サーバーのスペックをアップグレードするか、アプリケーションのリソース使用効率を向上させるために最適化を行う必要があります。

レスポンスの一部が頻繁に変更されない場合、キャッシュを導入してレスポンスの返却を高速化することができます。FastAPIはキャッシュライブラリをサポートしています。

データベースクエリがボトルネックになる場合、データベースクエリの最適化を検討してみてください。インデックスの追加やクエリのチューニングなどが役立つかもしれません。

これらのステップを試して、APIサーバーのパフォーマンスを向上させる手助けとなるでしょう。問題が解決しない場合は、詳細なプロファイリングやロギングを行い、具体的な問題点を特定することが重要です。

提供された情報から、APIサーバーが同時接続数が多くなる理由は明確にはわかりませんが、いくつかの一般的な理由が考えられます。同時接続数が多い場合、サーバーのリソースや処理能力に関連する問題が影響を及ぼす可能性があります。以下は考えられる理由です:

APIリクエストが別のバッチ処理から送信されていると記述されています。もしバッチ処理が瞬間的に多数のリクエストをサーバーに送信している場合、同時接続数が急増することがあります。

APIのリクエストによって、処理に時間がかかる場合、リクエストが待機状態になり、同時接続数が増加する可能性があります。この場合、非同期処理を活用してリクエストを非ブロッキングにすることで、同時接続数の制御が改善できます。

バッチ処理がサーバーに対して長時間の接続を保持し、ポリングを行っている場合、同時接続数が増加することがあります。この場合、WebSocketなどのプッシュ通知の仕組みを検討して、リアルタイム通信を改善できるかもしれません。

サーバーのスペック(CPU、メモリ)が同時接続数を処理するには不足している可能性があります。サーバーのスペックをアップグレードすることで、同時接続数を増やすことができます。

一部のクライアントがリクエストを送信し続けることがあり、これが同時接続数を増やす要因となることがあります。また、ネットワークの問題や遅延も同時接続数に影響を及ぼす可能性があります。

同時接続数が問題となる場合、まずは何が同時接続数を増加させているのかを特定し、その要因に対処する必要があります。リクエストのパターンや処理時間を監視し、適切な対策を講じることで、同時接続数の制御とサーバーパフォーマンスの向上が可能です。

プログラミング/インフラ・クラウド, AWS, Docker

【利用目的】

技術的な質問・相談, ポートフォリオ添削, 個人開発相談

【具体的な相談内容】

現在、ポートフォリオが形になり始め、一旦、AWSへアプリをデプロイしようとしています。

以下の参考サイト通りに4回ほどデプロイに挑戦してみましたが、エラーに見舞われ、自分なりに考えて修正等を試みたのですが、それでも一向にエラーが解消できずにいます。

【参考にしたサイト】

https://zenn.dev/prune/books/28c2d690e11e45

【アプリ仕様】

・React

・RailsAPI

・docker-compose

・Docker

・S3

・Fargate

【お願いしたいこと】

・Fargateを使用してアプリをデプロイしたい。

→現在の内容で、「どの部分が誤っているのか」ご指摘頂きたいです。

・更に、欲を言えばcircleCIを導入したい。

・デプロイに関する技術や知識をご指導いただきたい。

【最後に】

アプリケーションを作成し始め、半年以上が経過しました。今まで自分で調べてなんとかやってこれましたが、AWSの複雑さに翻弄されています。

当方、初心者も初心者ですが、何卒ご指南頂きたく、どうぞよろしくお願いいたします。

まず、Fargateを使用してReactとRailsAPIのアプリケーションをAWSにデプロイし、さらにCircleCIを導入する際のアドバイスを提供します。AWSのデプロイに関するエラーの解決をサポートするために、以下のステップを確認してみてください。

AWSのアカウントを正しく設定していますか?必要なアクセス許可があることを確認しましょう。

AWS CLIが正しく設定されていることを確認し、必要な情報(リージョン、アクセスキー、シークレットキー)が正確であることを確認してください。

Docker Composeファイルが正しく設定されていることを確認してください。各サービスの設定が適切であるか確認しましょう。

Dockerイメージを正しくビルドできているか確認し、必要なイメージがローカルに存在することを確認しましょう。

S3バケットが適切に設定され、アプリケーションでのアクセス許可が正しく構成されていることを確認してください。

Fargateタスク定義が正しく構成され、必要なコンテナイメージが指定されていることを確認しましょう。

Fargateタスクが適切なセキュリティグループおよびVPCに関連付けられていることを確認してください。

AWSのエラーメッセージやログを確認し、具体的なエラーの内容を特定しましょう。それに基づいて問題を解決できるかもしれません。

CircleCIを導入する際には、リポジトリ内に.circleciディレクトリを作成し、設定ファイルを追加します。CircleCIのドキュメントを参考にして設定を行いましょう。

AWSやDocker、Fargate、CircleCIなどのテクノロジーに関する知識を向上させるために、公式ドキュメントやオンラインリソースを積極的に利用しましょう。

問題が特定のステップで発生している場合、具体的なエラーメッセージやログを共有することで、より具体的なアシストができます。また、特定の問題に関する質問があれば、随時お知らせいただければ幸いです。

X(旧Twitter)の利用規約の変更が9月29により始まる

要点をまとめる

発効日: 2023年9月29日

写真や動画など投稿した内容については非独占的ライセンスとなり

有料の利用者はダウンロードし二次加工を容認している

インフラなどの費用負担など、かなりXの経営を圧迫していることがうかがえる

ただ、このようにしていけば、写真や動画について、Xを利用することは減りそうだ

また広告が増えると、見たくない人もいるが、ブロックできず、ミュートだけ

今後急速に利用者が減りそうだ

青い鳥を失った企業、将来はどうなるのでしょう

見守りましょう

ブランチ戦略は、一般的なGitフローと呼ばれるもので、多くの場面で適切に機能します。特に、featureブランチが並行して複数発生した場合でも、Gitフローのルールに従えば、整合性を維持しつつ開発を進めることができます。以下は、提案として考えられるポイントです:

これらのツールはCI/CDパイプラインの自動化やアプリケーションのデリバリーに役立つツールであり、学習と実践を通じて活用できるようになることが可能です。

複数のAWSアカウントを扱う場合、セキュリティとリソース管理が重要です。DevOpsの観点から、以下のような知識が必要です:

GitLab CI/CDとArgo CDは、DevOpsプロセスの自動化とアプリケーションデリバリーを支援するためのツールです。それぞれのツールについて詳細に説明します。

GitLab CI/CDは、GitLabと統合された継続的インテグレーション(CI)と継続的デリバリー(CD)のプラットフォームです。以下はその主要な要素と機能です:

GitLab CI/CDは、ソフトウェア開発のパイプラインを自動化するための強力なツールです。コードの変更がリポジトリにプッシュされると、自動的にビルド、テスト、デプロイなどのアクションがトリガーされます。

CI/CDパイプラインはジョブとステージに分割され、各ステージには複数のジョブが含まれます。これにより、段階的なビルドおよびデプロイプロセスを簡単に定義できます。

GitLab CI/CDランナーは、ビルドジョブを実行するためのエージェントです。GitLabランナーを自己ホストすることも、GitLab.comの共有ランナーを利用することもできます。

GitLab CI/CDは、インフラストラクチャの管理(例: Dockerコンテナ、Kubernetesクラスタ)との統合をサポートしています。

ジョブの負荷に応じて自動的にランナーをスケーリングできます。

セキュリティスキャンを組み込み、コードの脆弱性を特定します。

CI/CDパイプラインを使用して、アプリケーションの自動デプロイメントを設定できます。

Argo CDは、Kubernetesクラスタ上で動作するツールで、GitOps(Gitを使用した運用)の原則に従ってアプリケーションをデプロイおよび管理するために使用されます。以下はArgo CDの主要な機能です:

Argo CDは、KubernetesマニフェストをGitリポジトリに保存し、Kubernetesクラスタ上のアプリケーション状態をGitリポジトリと同期します。これにより、アプリケーションのデプロイメントと構成がGitで管理され、変更の履歴が追跡できます。

Argo CDは、アプリケーションの異なるバージョンやパラメーターを簡単に切り替える機能を提供します。

Argo CDは、複数の環境(開発、ステージング、本番など)でアプリケーションを管理できます。

Gitリポジトリの変更が検出されると、Argo CDはクラスタ内のアプリケーション状態を自動的に同期します。

Role-Based Access Control(RBAC)を使用して、異なるユーザーやチームに対するアクセス制御を設定できます。

カスタムリソースを使用して、Kubernetesオブジェクト以外のアプリケーション構成も管理できます。

Argo CDは、アプリケーションの監視と通知をサポートし、問題が発生した場合にアラートを送信できます。

GitOpsの原則に基づくArgo CDは、Kubernetes上でアプリケーションのデリバリーと管理を効率化し、信頼性を向上させるのに役立ちます。

人間関係に悩む人に対する対応は、思いやりとサポートが必要です。

以下は、人間関係に悩む人に対する対応の仕方のいくつかのポイントです:

相手の話に耳を傾けましょう。感情や意見を尊重し、詳細を聞いて理解しましょう。ただし、解決策を提示するのではなく、まずは相手の気持ちに寄り添いましょう。

相手が悩みや問題を話す際、非難や批判を避けましょう。その代わりに、共感し、サポートの意志を示しましょう。

相手の感情に共感しましょう。 "私も同じように感じたことがあります" や "あなたの気持ちを理解します" といった言葉を使って、共感を表現します。

相手がそれを望む場合、一緒に問題の解決策を考える手助けをしましょう。しかし、解決策を押し付けるのではなく、相手の意見を尊重し、協力的にアドバイスを提供しましょう。

相手が話をしたくない場合やプライバシーを尊重したい場合、無理に話を引き出さないようにしましょう。自分から話すことを奨め、必要ならば後で話すこともできるようにしましょう。

相手の強みやポジティブな側面について肯定的なフィードバックを提供しましょう。自信を持たせ、前向きな視点を促しましょう。

時には、専門家の支援が必要な場合があります。心理カウンセラーや専門家のアドバイスを提案し、手助けをしましょう。

自身の経験を共有し、相手にとって励みになるエピソードを語ることができます。ただし、相手の問題に自分の話を押し付けないように気を付けましょう。

一度だけでなく、継続的に相手をサポートしましょう。問題が解決しない場合でも、忍耐強く支え続けることが大切です。

人間関係の問題に対処するために、自分自身も十分な休息とケアを怠らないようにしましょう。自分が安定していることが、他人をサポートする力につながります。

最も重要なのは、相手を尊重し、感情に寄り添うことです。相手の立場や感情を理解し、共感し、サポートすることが、良好な人間関係の基盤を築く鍵です。

AWSを使用してGitベースのCI/CD(Continuous Integration/Continuous Deployment)パイプラインを設定する計画を立てるために、以下のステップを考慮することが重要です。CI/CDパイプラインは、アプリケーションの自動化されたビルド、テスト、デプロイメントを可能にするもので、効率的な開発サイクルを実現します。

プロジェクトの要件の明確化:

バージョン管理システムの選定:

インフラストラクチャの設計:

ビルドツールの選定:

テスト自動化:

イメージ/アーティファクトの管理:

CI/CDパイプラインの設定:

デプロイメント戦略の設計:

モニタリングとログ管理:

セキュリティの確保:

自動化と自動デプロイ:

監視と最適化:

文書化とトレーニング:

継続的な改善:

以上のステップを考慮して、AWSを使用したGitベースのCI/CDパイプラインを設定し、アプリケーションの迅速な開発とデプロイメントを実現できるように計画を立てることが重要です。プロジェクトの要件や固有の状況に合わせて調整することが大切です。

Gitは非常に強力な分散型バージョン管理システムであり、多くのメリットがありますが、ブランチ管理が煩雑になる理由もいくつか存在します。以下に、Gitでブランチ管理が複雑になる主な理由をいくつか挙げてみましょう。

プロジェクトが成長するにつれて、多くの機能ブランチや修正ブランチが生まれることがあります。これらのブランチが増えると、どのブランチがどの機能や修正に関連しているのかを追跡するのが難しくなります。

長寿命のブランチ(例: メインブランチ、デベロップメントブランチ)は、プロジェクトの中心となる部分であり、常に安定している必要があります。しかし、これらのブランチの管理は煩雑で、コンフリクトの解決やコードのリリースに関連する問題が生じる可能性があります。

複数のブランチが同じファイルや行を変更した場合、マージコンフリクトが発生します。これらのコンフリクトを解決する必要があり、特に多くのブランチや作業者がいる場合、コンフリクトの解決が難しくなります。

ブランチ管理に関する適切な戦略を選択することが重要です。適切な戦略を選択しないと、ブランチの整理やリリースの計画が難しくなり、煩雑さが増します。

これらの理由から、Gitのブランチ管理は煩雑になることがあります。しかし、適切なワークフローやベストプラクティスを遵守し、適切に管理すれば、これらの問題を最小限に抑えることができます。例えば、定期的なコードレビューやCI/CDツールの活用などが役立ちます。

Anacondaは、Pythonのデータサイエンスと機械学習用のオープンソースのディストリビューションと仮想環境管理ツールです。

DjangoはPythonで書かれたWebアプリケーションフレームワークです。

Anacondaを使用してDjangoプロジェクトを管理することは可能ですが、Anaconda自体はDjangoを開発するための特別なツールではありません。

以下は、Anacondaを使用してDjangoプロジェクトをセットアップする一般的なステップです。

Anacondaを公式ウェブサイトからダウンロードし、インストールします。AnacondaにはPython本体と多くのデータサイエンスライブラリが含まれており、仮想環境の作成やパッケージの管理に便利です。

Anacondaを使用して、Djangoプロジェクトのための仮想環境を作成します。仮想環境はプロジェクトごとに異なるPython環境を提供し、依存関係の管理が容易です。以下のコマンドで仮想環境を作成します。

conda create --name myenv python=3.8

ここで myenv は仮想環境の名前で、python=3.8 はPythonのバージョンを指定しています。

作成した仮想環境をアクティベーション(有効化)します。

Windowsの場合は以下のコマンドを使用します。

conda activate myenv

macOS/Linuxの場合は:

source activate myenv

仮想環境がアクティブな状態で、Djangoをインストールします。

pip install django

Djangoプロジェクトを作成します。

django-admin startproject myproject

※myproject はプロジェクトの名前で、任意に変更できます。

Djangoアプリをプロジェクト内に作成します。

cd myproject

python manage.py startapp myapp

※myapp はアプリの名前で、こちらも変更可能です。

Djangoプロジェクトの設定ファイル(settings.py)でアプリを有効化します。

開発サーバーを起動し、Djangoアプリをローカルで実行します。

python manage.py runserver

これで、http://127.0.0.1:8000/ にアクセスしてDjangoアプリを確認できます。

Anacondaを使用することで、Djangoの環境を効果的に管理し、プロジェクトの依存関係を整理することができます。

Python DjangoアプリケーションをVisual Studio Code(VS Code)とDockerを使用して開発することは非常に一般的で効果的な方法です。

以下は、この開発プロセスの一般的なステップとアプローチです:

最初に、Djangoプロジェクトを作成します。これはDjangoのコマンドラインツールを使用して行えます。プロジェクトを作成したら、DjangoアプリケーションのコードをVS Codeで開きます。

Dockerをインストールし、Djangoアプリケーション用のDockerコンテナを作成します。Dockerコンテナは、アプリケーションの実行環境をカプセル化し、開発環境を他のシステムと分離します。

Docker Composeを使用して、Djangoアプリケーションコンテナだけでなく、データベースコンテナ(通常はPostgreSQLやMySQLなど)も含めた複数のコンテナを定義します。これにより、アプリケーションとデータベースの連携を容易に行えます。

Docker、Python、Djangoなどに関連するVS Codeの拡張機能をインストールします。これにより、コードのデバッグ、自動補完、リモートデバッグなどの便利な機能を利用できます。

VS Code内でターミナルを開き、DjangoアプリケーションとデータベースのDockerコンテナを起動します。Docker Composeを使ってコンテナを一括で管理できます。

Djangoの開発サーバーを起動し、コードの変更をリアルタイムで反映できるようにします。VS Codeの拡張機能を使用してデバッグセッションを開始し、デバッグを行うことも可能です。

VS Code内でDjangoアプリケーションのコードを編集し、デバッグを行います。VS Codeのデバッグ機能を活用して、ブレークポイントを設定し、変数の値を監視します。

開発が進むにつれて、Djangoアプリケーションのテストを作成し、コードの品質を確保します。また、コードやAPIのドキュメンテーションも重要です。

開発が完了したら、Djangoアプリケーションとデータベースのコンテナを本番環境にデプロイします。通常、CI/CDツールを使用して自動化されたデプロイプロセスを設定します。

このようなアプローチを取ることで、Djangoアプリケーションの開発を効率化し、環境の一貫性と可搬性を確保できます。VS CodeとDockerの組み合わせは、開発プロセスをシームレスにするための強力なツールです。

Apache Log4jの脆弱性が現在でも続いています

利用されている方は、脆弱性を排除しましょう

この文章は、Apache Log4jと呼ばれるJavaベースのオープンソースのロギングライブラリに存在する脆弱性に関する情報を提供しています。以下に詳細をまとめます。

文書は2022年1月4日の情報で、状況が変わる可能性があることを指摘しています。

Apache Log4jのバージョン2.17.1(Java 8以降)、2.12.4(Java 7)、および2.3.2(Java 6)が公開されました。

脆弱性(CVE-2021-44228)により、攻撃者がログデータを利用して任意のコードを実行できる可能性があります。

影響を受けるバージョンは、Apache Log4j-core 2.15.0より前の2系のバージョンです。

Apache Log4j 1系のバージョンは影響を受けないことが確認されています。

Apache Software Foundationから修正されたバージョンが提供されており、アップデートを推奨しています。

2.16.0と2.12.2ではLookup機能がデフォルトで無効になりました。

脆弱性への対策として、アクセス制御の見直しや強化も推奨しています。

特定のバージョンでは、JndiLookup.classをクラスパスから削除する回避策を提供しています。

システムから外部への接続を制限するアクセス制御も検討しています。

Apache Log4jの脆弱性に関する情報源やリンクが提供されています。

JPCERT/CCなどの情報提供機関と連絡を取ることが推奨されています。

この文書は、Apache Log4jのセキュリティに関心のあるユーザーに対して、脆弱性に対処するための情報を提供しています。

量子力学の原理を利用して計算を行うコンピュータのことです。

量子コンピュータは、従来のコンピュータとは異なる計算モデルを持ち、一部の問題に対しては指数関数的に高速に解くことができます。例えば、素因数分解や機械学習などの応用分野で、量子コンピュータの優位性が期待されています。

量子ビットと呼ばれる情報の単位です。量子ビットは、0と1の状態を同時に持つことができるという特徴を持ちます。これにより、量子ビットの数が増えると、表現できる状態の数が指数関数的に増加します。例えば、2つの量子ビットは、0と1の4通りの組み合わせを同時に表現できます。

しかし、量子ビットは非常にデリケートで、外部のノイズや測定によって状態が変化してしまう可能性があります。そのため、量子ビットを安定に制御することは、量子コンピュータの最大の課題です。

進められています。特に、GoogleやIBMなどの大企業や、中国や米国などの政府も積極的に投資しています。

量子コンピュータはまだ実用化されていませんが、近い将来、社会に大きな変革をもたらす可能性があります。このブログでは、量子コンピュータの最新情報や基礎知識を分かりやすく紹介していきます。

Pythonを使用したWebスクレイピングは、データ収集や情報収集の重要な手法として広く利用されています。卒業論文のテーマとしてWebスクレイピングを選ぶことは、データ分析、ビジネスインテリジェンス、マーケティング、学術研究など多くの分野で有益な情報を提供できます。以下はいくつかのWebスクレイピングに関連するテーマの提案です。

ウェブスクレイピングを使用してデータを収集し、そのデータを機械学習モデルに供給して予測や分類を行うプロジェクトを検討します。たとえば、商品の価格予測、航空券価格の予測、感情分析などのアプリケーションが考えられます。

ウェブスクレイピングを用いて競合他社のデータや市場動向を監視し、ビジネス戦略を策定する方法に焦点を当てる研究が考えられます。これにより、競争優位性を確立するための情報を収集する方法を調査できます。

ウェブスクレイピングに関連する法的および倫理的な問題に焦点を当て、データの収集と使用に関連する法的制約や倫理規範についての研究を行うことができます。これは、データプライバシーや著作権などの問題を含むことがあります。

ウェブスクレイピングプロセスを自動化し、大規模なデータセットの収集と処理を効率化する方法について研究します。クローリング速度の最適化やリソース管理に焦点を当てることができます。

ウェブスクレイピングを使用して政府政策、選挙、社会的問題に関するデータを収集し、その情報が政策決定や社会への影響に及ぼす可能性についての研究を行います。

ウェブ上の情報の信頼性についての研究。スクレイピングデータの品質と信頼性を評価し、信頼性の高い情報源を特定する方法に焦点を当てます。

ウェブスクレイピングに関連するテーマは多岐にわたり、特定の関心や専門知識に合わせて選択できます。適切なテーマを選び、十分なデータ収集、分析、倫理的な配慮を行うことが成功の鍵です。また、選んだテーマに応じて法的な規制やライセンスにも留意することが重要です。

どちらも有名どころのデパート

西武線に住んでいた時は、西武池袋店はよく行っていたことを思い出す

かつては多くの人でにぎわい、売上高も大きかった

でも今では、デパートに行く人が少ない

今、デパートに日々行く人は少ないのではないでしょうか

行ったとしても、買物をしない人が多そう

デパート自体が変わらないと売上はきつい業態であることは確か

根本的な変革がないと、さらに時代から取り残されるでしょう

厳しい業界です

業態改革をしない企業には未来がないという典型的なパターンです

原子力発電所とトリチウムとの関係について

トリチウムは、水素の同位体の一つであり、原子番号1(H)の元素の中でも中性子の数が最も多い同位体です。トリチウムは放射性同位体であり、主にベータ崩壊を経てヘリウムに変換されます。その放射能は比較的弱いため、人体に対する直接的な影響は限られていますが、長時間にわたって体内に取り込まれることがあるため、適切な管理が必要です。

原子力発電所において、トリチウムは一般的に軽水炉や重水炉の冷却材として使用されている水中に微量含まれています。これは、核反応が進行する過程でトリチウムが生成されるためです。トリチウムを含む水が原発の排水として環境に放出されることがあるため、その管理や放出の規制が重要な問題となっています。

一般的に、トリチウムは放射能が比較的低いため、適切な取り扱いが行われれば健康への影響は限られます。ただし、放射性物質であるため、その取り扱いや廃棄物管理には注意が必要です。原子力発電所のトリチウム排水が環境への影響をどの程度持つかについては、科学的な評価と規制が行われています。

トリチウムの放出や取り扱いに関しては、国や地域によって異なる法規制や基準が存在することがあります。原子力発電所は、これらの法規制と基準を順守しながら、トリチウムの管理を行う必要があります。

科学的な安全性と人が思う安全性は違う

絶対の安全性は保証されているわけではないが、自然に存在することは確かです

安全有無というより、感情的には嫌ものです

今までに大きな計画を見て素晴らしいのはアポロ計画

ただし、犠牲者も出ている

技術的発展や安全性についてはその後改善されている

そしてその膨大な費用は、大きい

科学の発展や宇宙への興味は多くの人がこのころ抱いている

アポロ計画は、アメリカ合衆国が宇宙空間への有人月面着陸を達成するために行った一連の宇宙計画です。1960年代から1970年代にかけて実施され、1969年に初めて人類が月面に着陸した際のアポロ11号が最も有名です。以下に、アポロ計画の詳細を初心者にも理解しやすい形で説明します。

冷戦時代、アメリカとソビエト連邦(現在のロシア)との間で宇宙競争が繰り広げられていました。1957年にソビエトが人工衛星スプートニク1号を打ち上げたことで、アメリカは宇宙技術の遅れを認識しました。アポロ計画は、アメリカが宇宙での優越性を示すため、そして科学的な知識を拡充するために始まりました。

アポロ計画は、アポロ1号から始まり、計画段階やテスト飛行を経て、アポロ11号が有人月面着陸を達成しました。その後も、アポロ12号から17号までの計6回の有人月面着陸が行われました。

1969年7月20日、アポロ11号の宇宙船「イーグル」が月面に着陸し、ニール・アームストロング船長が「人類にとって小さな一歩、人類にとって大きな飛躍」という有名な言葉を残しました。彼は月面を歩き、エドウィン・"バズ"・オルドリン中尉も同行しました。この出来事は人類史上の偉業となりました。

アポロ宇宙船は、司令船と月着陸船から成り立っていました。司令船は宇宙飛行士が居住し、地球帰還に使用されました。月着陸船は月面に降り、船長と船員が月面活動を行いました。

アポロ計画は多くの技術的課題に立ち向かいました。有人宇宙船の設計や遠距離通信、月面での生存、再突入など、多岐にわたる問題がありましたが、科学者やエンジニアたちはそれらの課題を克服しました。

アポロ計画は、科学的な知識の増加だけでなく、技術の進歩や国際的な協力の重要性を強調する事例としても記憶されています。また、宇宙探査への関心を高め、後の宇宙計画や技術の基盤となりました。

アポロ計画は、人類が月に到達し、地球外の世界を探索する歴史的な出来事であり、科学、技術、勇気、協力の象徴として広く称賛されています。

ChatGPTを利用して展開

美女と野獣のストーリーをベースにして、主人公の美女をシンデレラに置き換えた場合の新たなストーリーを考えてみましょう。

シンデレラは、小さな村に住む優しい心を持つ若い女性です。彼女は幼少期に母親を亡くし、その後、優しい父親と共に平穏な日々を送ってきました。しかし、父親が遠くの町に出かけてしまった後、シンデレラは継母とその2人の娘たちと暮らすことになりました。

ある冬の日、父親が戻るはずの帰り道で遭難し、シンデレラは深い森で彼を捜しに行きます。その森で、彼女は奇妙な古い城を見つけます。城に入ると、そこには呪いによって野獣に変えられた王子が住んでいました。シンデレラは、父親が野獣に捕まっているのを発見し、代わりに自分を捕虜にすることを提案します。

野獣の城では、シンデレラは不思議な家具や道化師のような仲間たちと出会います。彼らは元々は人間だったが、呪いによって家具や生き物に変えられてしまった者たちです。初めての数日間は緊張と不安が続きますが、シンデレラは次第に彼らと友情を築いていきます。

物語は、シンデレラと野獣、そして仲間たちとの交流と成長、呪いを解くための方法を見つける冒険、そして真実の愛がどのように障壁を越えて勝利するのかを描きます。

この新たなストーリーでは、シンデレラの優しさと勇気が、野獣と仲間たちの心を開かせ、呪いを解く手助けとなるでしょう。

ChatGPTでベースとなる物語、変更することも可能です

実写版はディズニ⁺でよく鑑賞し、とても感動、ストーリーが良くできていて納得できるシーンが多い

何回観ても感動します

2015年の実写版「シンデレラ」について、主な配役とストーリーの詳細、いくつかのエピソードをご紹介します。

シンデレラ役: リリー・ジェームズ

王子役(キット王子): リチャード・マッデン

継母役: ケイト・ブランシェット

女の子の鼠役(ジャック): フランコ・ナヒュエル

フェアリー・ゴッドマザー役: ヘレナ・ボナム=カーター

王様役: デレク・ジャコビ

王妃役: ヘイリー・アトウェル

物語は、シンデレラと呼ばれる美しい少女の運命を中心に描かれます。シンデレラは、優しい父親と幸せな暮らしを送っていましたが、父親が再婚し、継母とその2人の娘たちと一緒に住むことになります。しかし、父親が急死した後、シンデレラは虐げられ、家事の奴隷のような扱いを受けるようになります。

ある日、王国で開かれる舞踏会に行くことを夢見るシンデレラは、森で美しい服を着た男性と出会います。その男性は、実は王子で、キット王子と名乗っていました。彼は王国の伝統的な舞踏会を開くことになり、全ての婚約者候補を招待しています。

シンデレラの運命は、フェアリー・ゴッドマザーによって大きく変わります。ゴッドマザーの魔法によって、シンデレラは美しいドレスを身にまとい、ガラスの靴をはいて舞踏会に参加することができるようになります。しかし、魔法は夜が明けるまでしか続かず、シンデレラは夜が明ける前に城を去る必要があります。

物語は、シンデレラと王子の出会いと恋愛、そしてガラスの靴を履いた正体不明の美女を探し続ける王子の努力を描きながら進行します。

これらのエピソードが、「シンデレラ」の魅力的なストーリーを構築しています。

鑑賞してみるとはまってしまった

配役の人たちも他の映画でよく知っているので、面白い映画です

急に歌い出すのは苦手ですが・・・

「美女と野獣」は、ディズニーのアニメーション映画を基にしたいくつかの実写映画の中で、2017年に公開された作品があります。以下に、その実写版「美女と野獣」の主な配役とストーリーの詳細、いくつかのエピソードをご紹介します。

ベル(美女)役: エマ・ワトソン

プリンス/野獣役: ダン・スティーヴンス

ガストン役: ルーク・エヴァンス

レフウ役: ジョシュ・ギャッド

モーリス役(ベルの父): ケヴィン・クライン

メイドのルミエール役: ユアン・マクレガー

シャペルのクロード役: イアン・マッケラン

ティーカップのチップ役: ネイサン・マッケンジー

クローゼット役: オードラ・マクドナルド

ポット夫人のムル役: スタンリー・トゥッチ

物語は、フランスの小さな村に住む美しい少女ベルと、自分自身を野獣として隠している呪われたプリンス(アダム)との間で展開されます。アダムは魔法使いによって野獣に変えられ、城とその住人たちも家具や調度品に姿を変えられました。アダムとその仲間たちは、花の一輪が最後に散る前に真実の愛を見つけなければ永遠にその状態が続くことになります。

ベルは図書館で知識を求める知的な少女であり、村の中では浮いた存在です。村の英雄であるガストンは、ベルに求婚しますが、ベルは彼の執拗なアプローチに嫌悪感を抱いています。

ある日、モーリスが野獣の城に迷い込み、野獣に捕まります。ベルは父を救うため、自ら城に向かい、自分を犠牲にして父を野獣の捕虜と交代させます。しかし、ベルは徐々に野獣やその仲間たちと交流を深め、心の中で彼らの人間性を見出していきます。

物語は、ベルと野獣の成長する愛と、城の住人たちの呪いを解く方法を見つけるための努力、そしてガストンの悪意による緊張を描きながら進行します。

これらは一部のエピソードとハイライトですが、映画全体は美しい音楽と感動的なストーリーが組み合わさっています。

情報セキュリティとは、コンピュータやネットワークを使用してデータを送受信する際に、そのデータが正当な利用者だけに適切に保護されることを確保するための対策や手段です。

情報セキュリティの主な目標は以下の通りです:

情報セキュリティは継続的な取り組みが必要であり、進化する脅威に対抗するために常に最新の情報をキャッチアップすることが大切です。

確かに、ChatGPTはさまざまな場面で便利な機能となっていますね。

ただし、図の作成などの視覚的な要素に関しては、ChatGPT自体では対応できない点に注意が必要です。図やグラフの作成には専門的なツールやソフトウェアが必要となるでしょう。

総じて言えることは、ChatGPTはテキストベースのタスクにおいて非常に強力な支援を提供してくれるツールですが、専門的な分野や複雑なタスクに取り組む際には、その限界も考慮しながら活用することが重要です。

楽天Edyアプリをご利用の方は、楽天Edyアプリで機種変更のお手続きが必要です。

機種変更の手続きには楽天IDが必要です。

旧端末で、楽天Edyアプリより機種変更のお手続きをします。

STEP2 新しい端末で初期設定

機種変更に伴う資料

MNP(携帯電話番号ポータビリティ)や携帯電話番号の変更なく機種変更をした場合は、新しい携帯電話端末でPayPayアプリにログインいただくことで、残高や設定等はそのままで引き続きPayPayをご利用いただけます。

4. ログイン認証が表示された場合は、ログイン認証を実施

新規の端末でログインする場合、SMSまたはQRコードを利用した認証を求められる場合があります。

機種変更に伴う資料

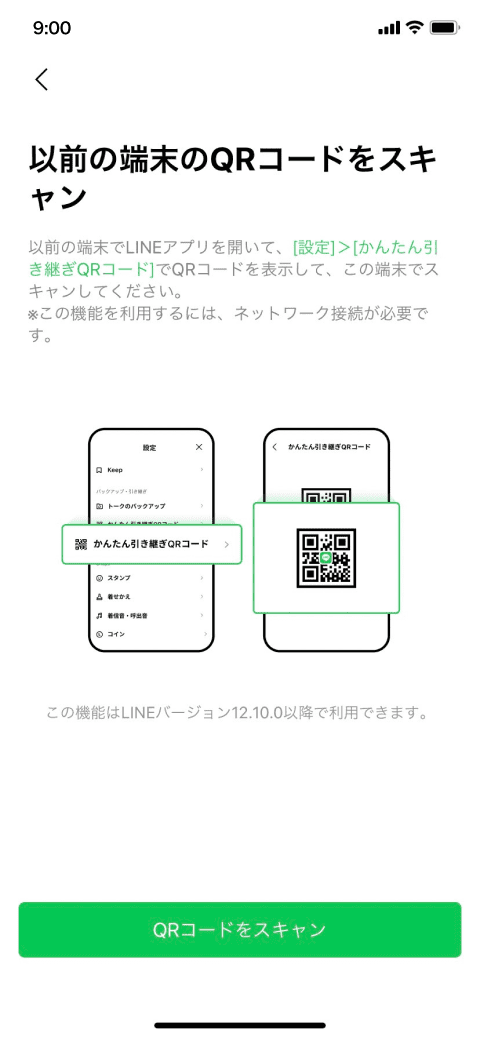

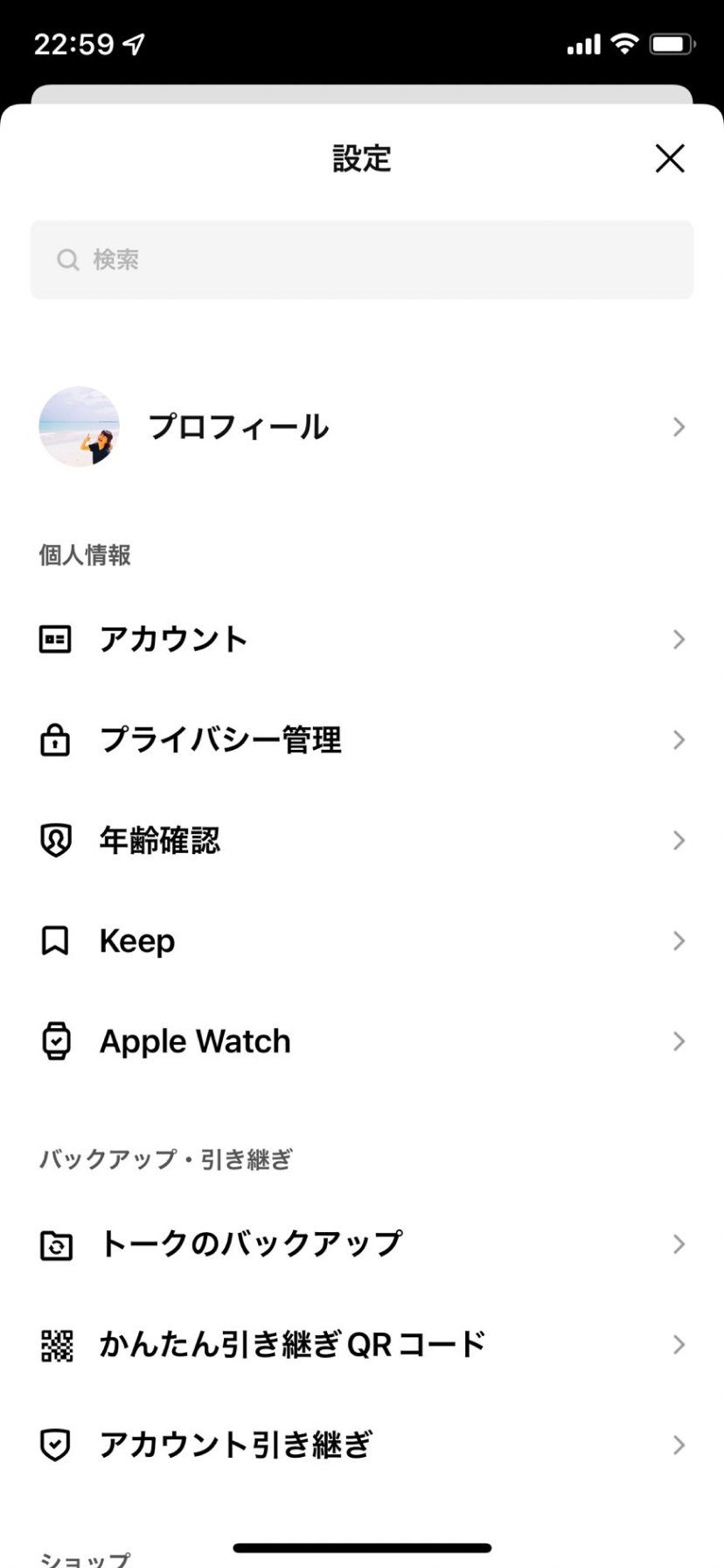

LINEバージョン12.10.0以上の場合、QRコードをスキャンするだけで、パスワード入力不要でかんたんに引き継ぎができる。

これまで異なるOS間の引き継ぎや、バックアップデータがない場合、トーク履歴の復元ができませんでしたが、かんたん引き継ぎQRコードによる引き継ぎの場合、直近14日間分のトーク履歴の復元が可能です。

また、同じOS間でバックアップをとっている場合には、直近14日間分のトーク履歴に加え、バックアップ分のトーク履歴の復元が可能です。

アカウント引き継ぎの際、これまで利用していた端末が手元にある場合には、かんたん引き継ぎQRコードによるアカウントの引き継ぎがおすすめです。

新しい端末とこれまで利用していた端末のバージョンが以下に該当するか確認する。

また、これまで利用していた端末で、事前にトーク履歴のバックアップ。

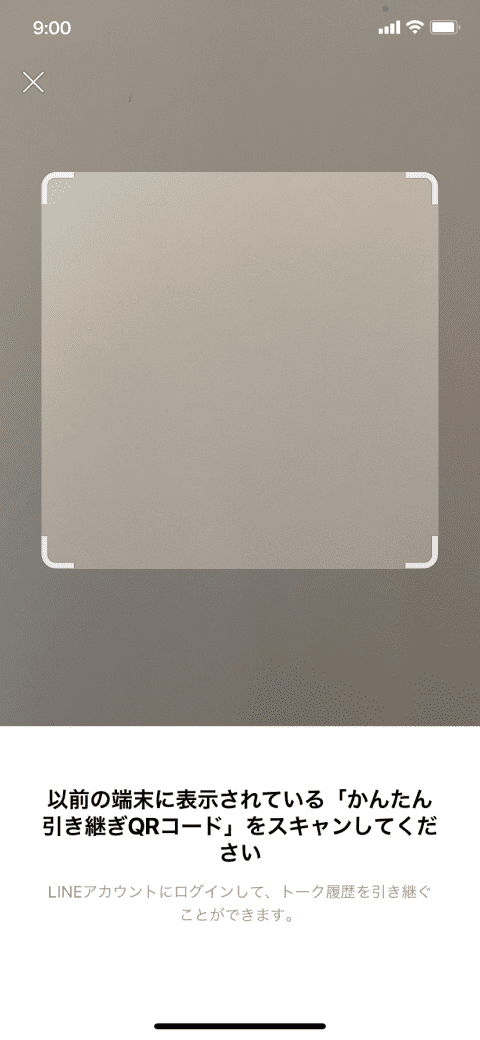

1.新しい端末でLINEを起動し、[ログイン]をタップ

2.[QRコードでログイン]を選択し、[QRコードをスキャン]をタップ

3.これまで利用していた端末でQRコードを表示

利用していた端末でLINEを起動し、[ホーム]>[![]() ]>[かんたん引き継ぎQRコード]からQRコードを表示

]>[かんたん引き継ぎQRコード]からQRコードを表示

※この時点でトーク履歴のバックアップを行っていない場合は、必ずバックアップの設定を確認してください。

4.新しい端末でQRコードをスキャンする

利用していた端末で表示させた「かんたん引き継ぎQRコード」を新しい端末でスキャン

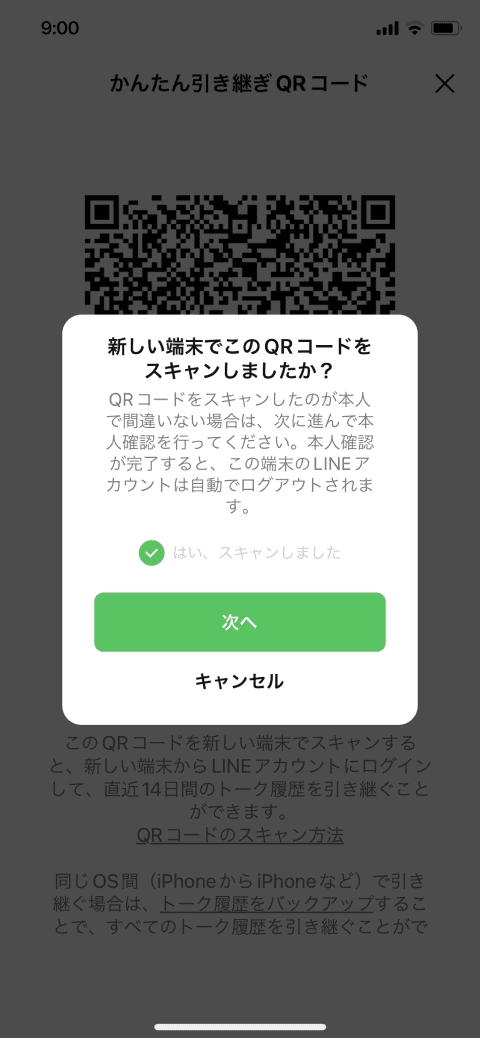

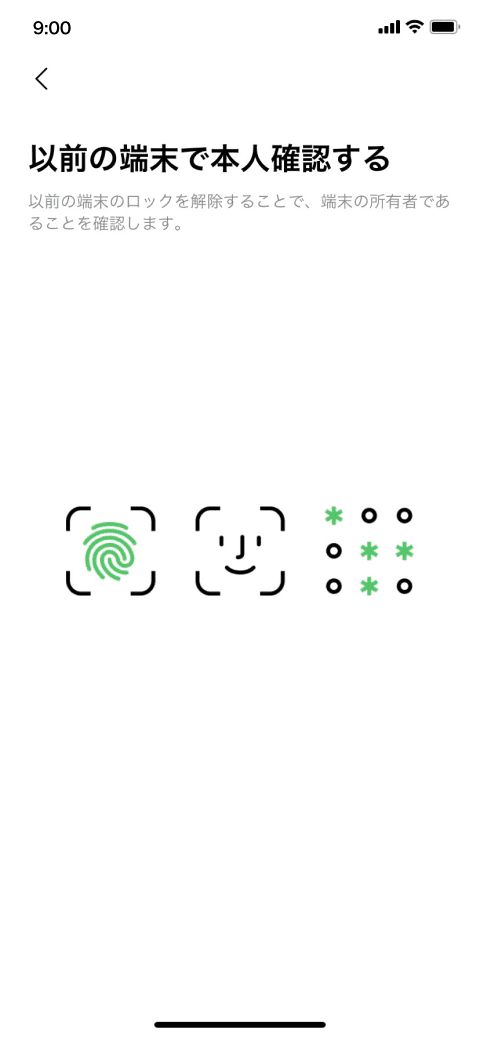

5.これまで利用していた端末で本人認証を行う

QRコードをスキャンしたあと、利用していた端末では「新しい端末でこのQRコードをスキャンしましたか?」と表示されるので、[次へ]をタップしてください。その後、利用していた端末のロックを解除することで、所有者であることを確認します。

6.トーク履歴を引き継ぐ

同じOS間(AndroidからAndroidなど)の引き継ぎで、かつバックアップが完了している場合、[トーク履歴を復元]をタップして、直近14日間のトーク履歴に加え、バックアップデータを復元します。

///////////////////////

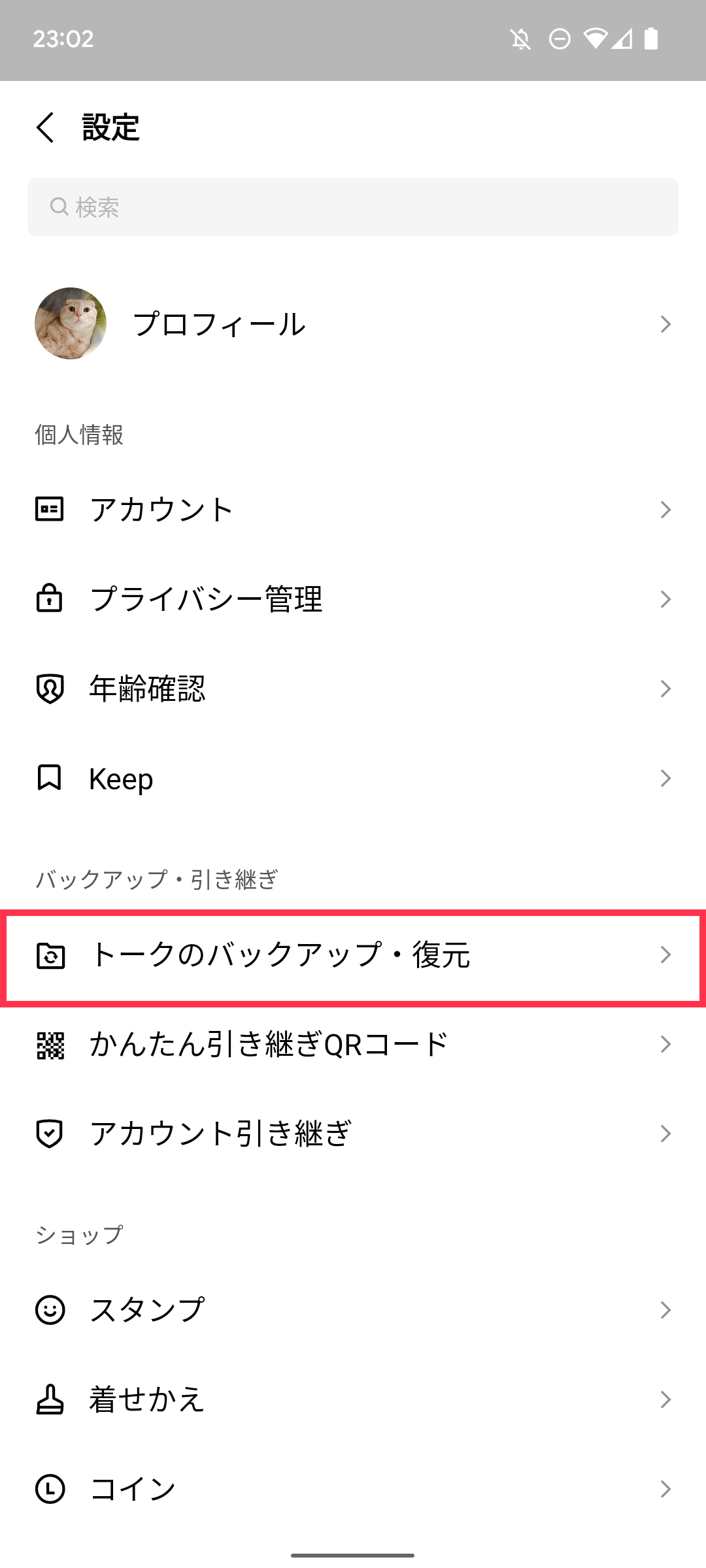

機種変更をして、LINEアカウントの引き継ぎをしたときに、トークの内容が消えていたということありませんか?トークの内容はスマートフォン内に保存されているので、機種が変わったときには、トーク履歴のバックアップが必要になります。

Androidでトーク履歴をバックアップする

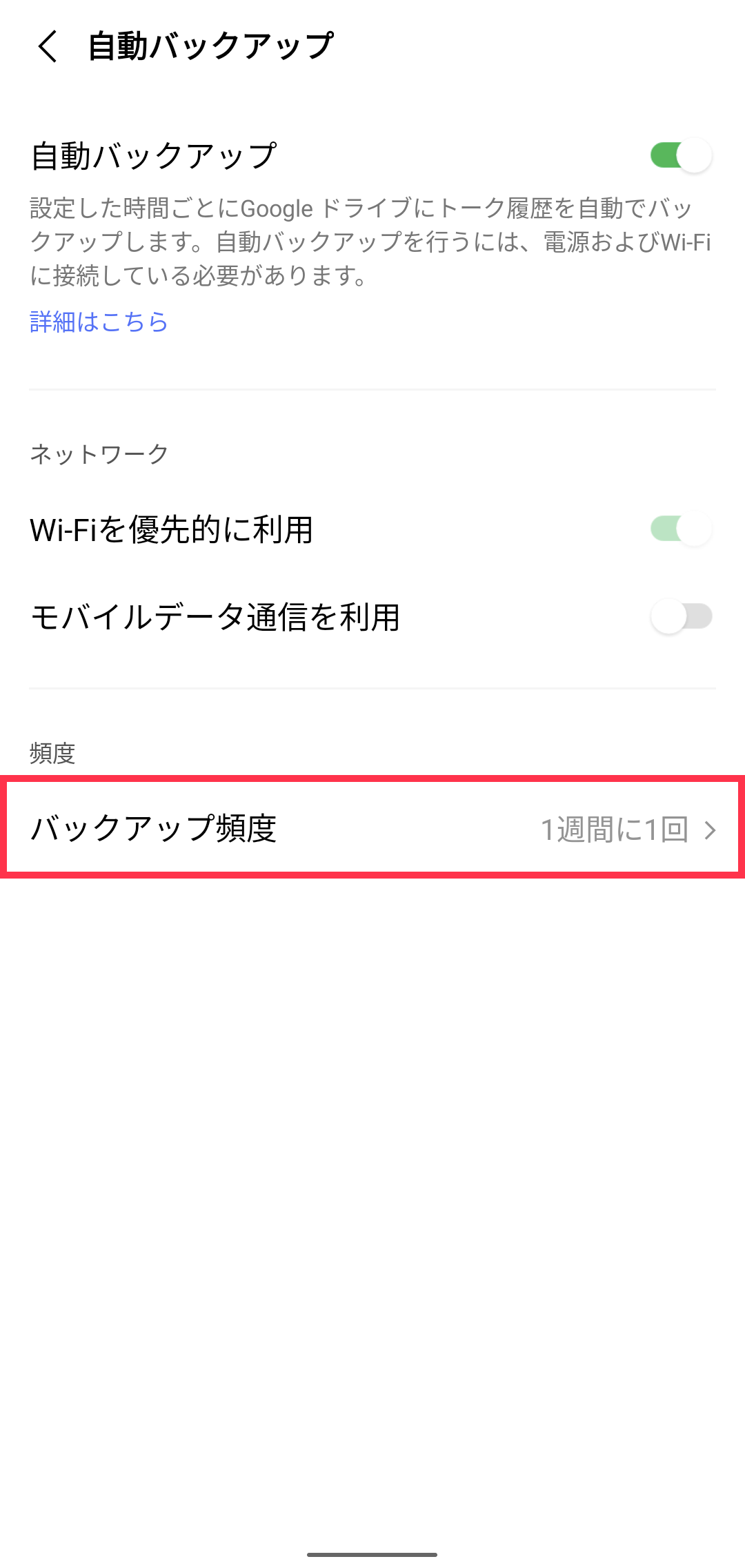

Androidをご利用の方は、Googleドライブを使ってトーク内容のバックアップが可能です。バックアップの設定には、任意のタイミングでバックアップを行う「手動設定」と、設定した頻度で自動的にバックアップを行う「自動設定」の2つの方法があります。スマホを新調する際や、スマホの故障・紛失によって予期せぬ機種変更が発生する場合に備え「自動バックアップ」がおすすめです。

※バックアップの自動設定はAndroid版 LINE10.10.0バージョン以上でご利用いただけます。

LINEバージョン7.5.0以上

※バックアップを行う際は、端末やGoogleドライブに十分な空き容量を確保し、電波の良好な場所で操作をお試しください

1.[ホーム]>[![]() ]>[トークのバックアップ・復元]をタップ

]>[トークのバックアップ・復元]をタップ

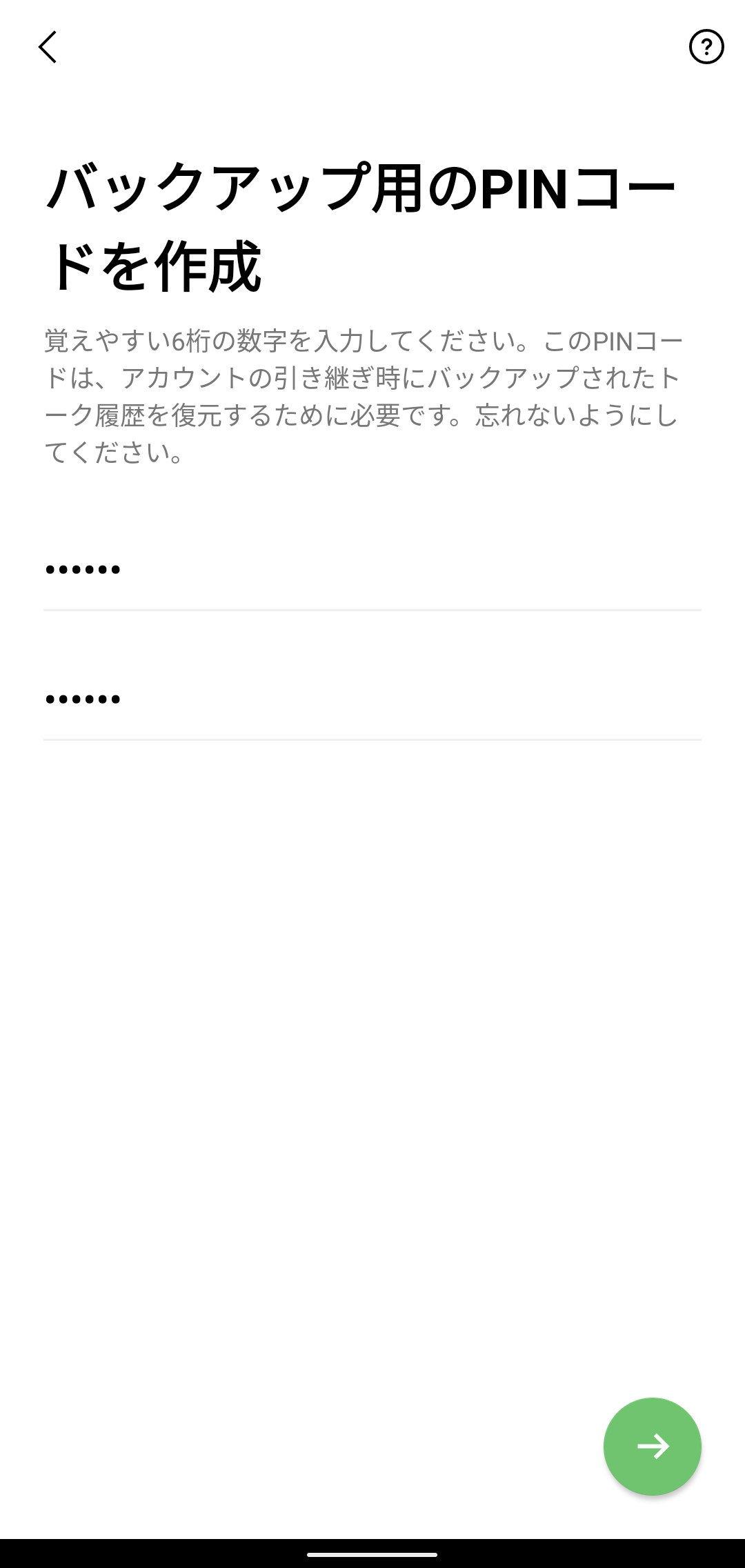

2.初めてトークのバックアップを取る場合は、[今すぐバックアップ]をタップして、6桁のPINコードを入力することで、最初にバックアップが行われます。

※LINEのバージョン12.13.0以上で、スマホが故障・紛失してしまった場合でも、スムーズにトーク履歴が復元できるバックアップ用のPINコードが登録できるようになりました。

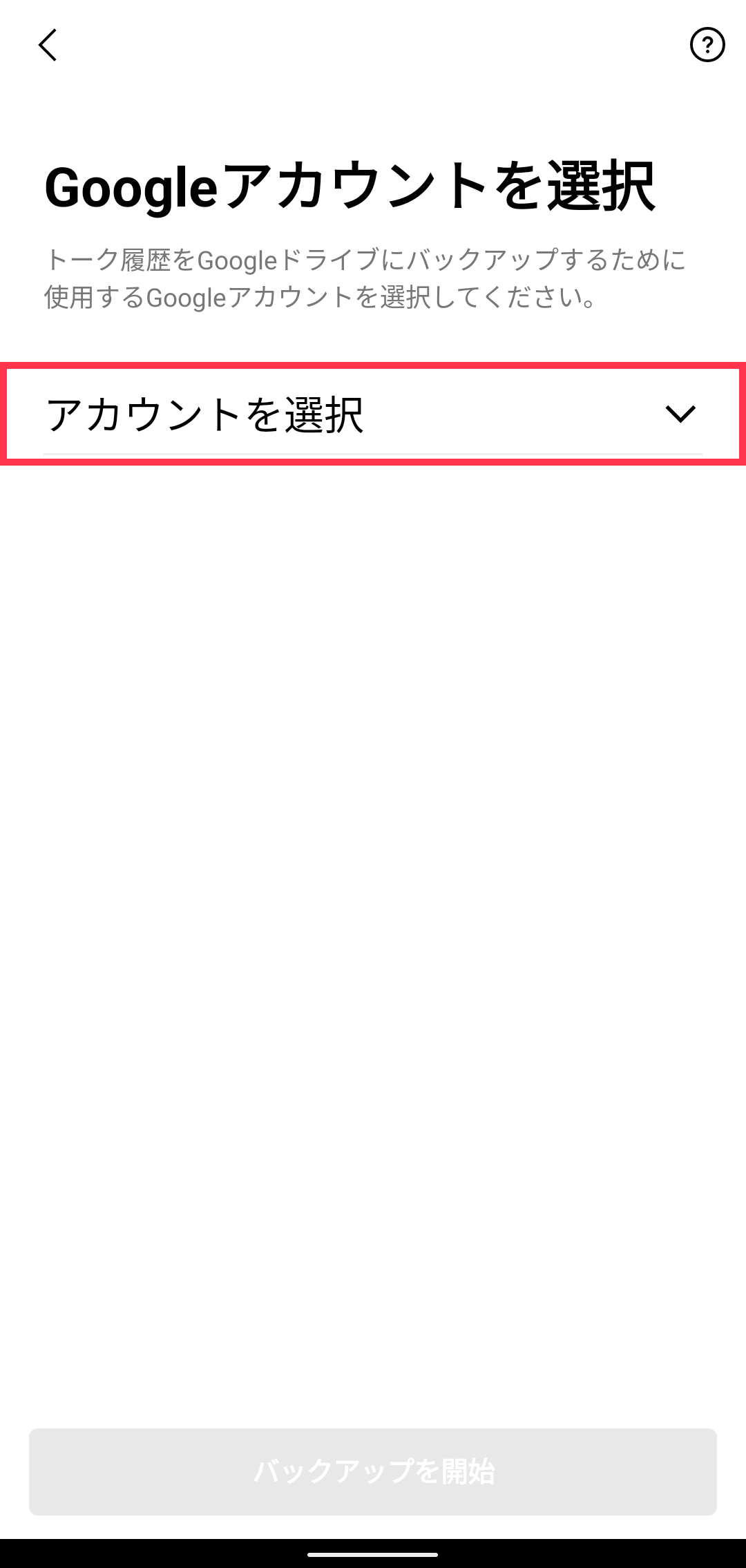

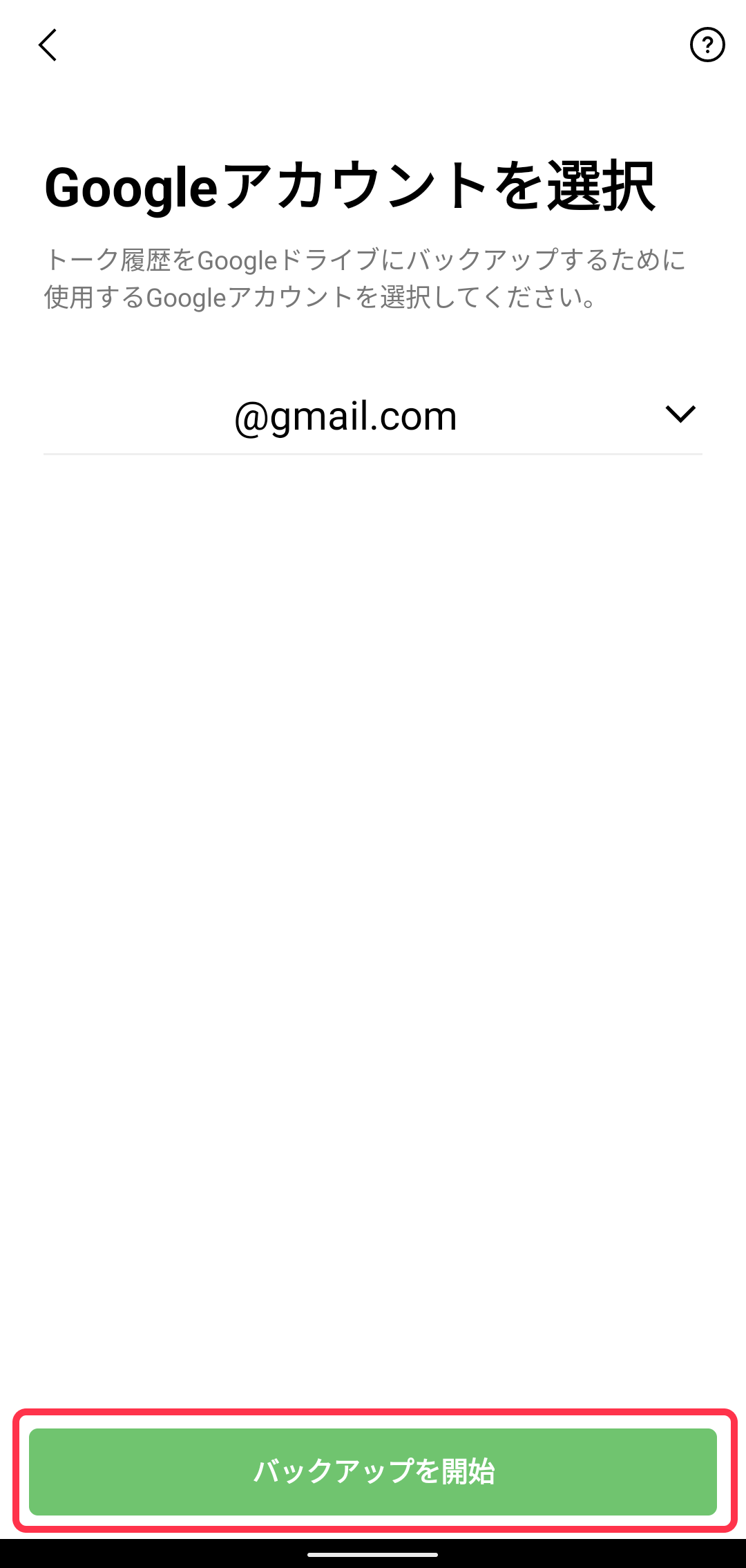

3.Googleアカウントを選択

※事前にGoogleアカウントとの連動が必要です

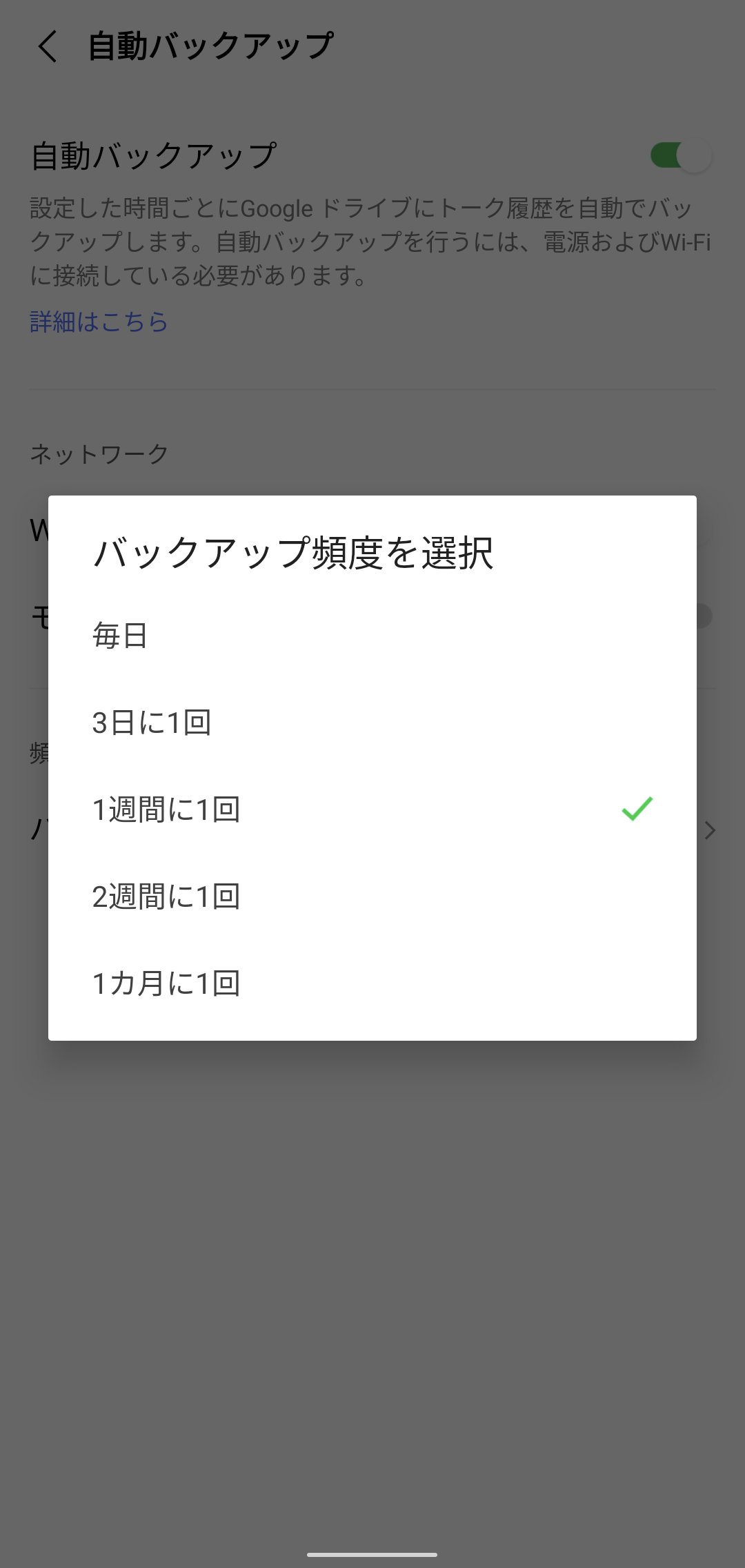

4.[バックアップ頻度]をタップし、自動でバックアップする頻度を選択すれば設定は完了です。

ChatGPTにテスト

DNSサーバの中でも、一般のユーザーが自身のコンピュータやネットワークに設定することなく、インターネット上のドメイン名の解決を行うためのDNSサーバを「オープンリゾルバ(Open Resolver)」と呼びます。

オープンリゾルバは、以下の特徴を持ちます:

オープンリゾルバは一般的に利便性の面で便利ですが、不適切な設定やセキュリティの問題から、悪意ある攻撃のリレー点にもなり得ます。そのため、セキュリティ対策や適切な管理が重要です。また、一部のオープンリゾルバは、特定の制約(利用回数の制限など)を設けている場合もあります。

※オープンリゾルバ、セキュリティ的に問題が多いので利用しないことが多い

ChatGPTのテストを兼ねて

『DNS ゾーン設定 詳細』として

DNSゾーン設定は、DNSサーバが特定のドメイン名に関連するリソースレコードを管理するための設定です。DNSゾーンは、一つ以上のドメイン名(例:example.com)とそのサブドメイン(例:subdomain.example.com)に対応するリソースレコードの集合です。

DNSゾーン設定には、以下の主要な要素が含まれます:

DNSゾーンの設定は、通常テキストファイル(BIND形式など)やDNS管理ツールを使って行います。一般的なDNSゾーン設定の例として、以下のようなリソースレコードが含まれます:

DNSゾーン設定には注意が必要で、正確な情報を提供し、不要なリソースレコードを避けることが重要です。誤った設定は名前解決の失敗を引き起こす可能性があります。

ChatGPTのテスト

『DNSサーバ 意味 設定』

DNSサーバ(Domain Name System Server)は、インターネット上のコンピュータネットワークにおいて、ドメイン名とIPアドレスの相互変換を行うサーバです。

インターネット上のコンピュータは、通常IPアドレスによって識別されます。しかし、人間にとって覚えやすいドメイン名(例:www.example.com)を使用して、コンピュータにアクセスすることが一般的です。このドメイン名とIPアドレスの対応を管理するのがDNSサーバの役割です。

具体的には、DNSサーバは次のような機能を持ちます:

DNSサーバの設定は、ネットワーク管理者が行います。主な設定項目は以下の通りです:

DNSサーバの適切な設定は、インターネット上で正常な名前解決が行われるために非常に重要です。

ChatGPTのテストを兼ねて

『ランサムウェア 対策』として

ランサムウェアは、コンピューターシステムに侵入してファイルやデータを暗号化し、その復号化キーを提供する代わりに、身代金(ランサム)を要求する悪意のあるソフトウェアです。

ランサムウェアに感染すると、ファイルやデータが利用不能となり、身代金を支払わない限り情報にアクセスできなくなる可能性があります。以下に、ランサムウェアに対する一般的な対策をいくつか挙げてみます:

これらの対策は、完全な防御を保証するものではありませんが、ランサムウェアに対するリスクを低減する助けになるでしょう。セキュリティ対策には常に最新の情報とベストプラクティスを参考にすることをおすすめします。

7月になり、Twitterの制限がきつくなり、タイムランが見えなくなったり、ツィートができないや、いいねができないなどの不具合が発生した

Twitterにはかなりの情報量があり、ここから『スクレイピング』が多く行われていた

そのため、Twitterのインフラ費用が増大していたのは事実

だが、制限を厳しくすると、広告を出すほうも見ているほうも利用しずらい

何をやりたいのか、方向性の見えないTwitter、利用者は大混乱してします

私もその一人です

情報の検索、それに関連した情報、リアル性にかけてはTwitterがダントツに強い

Metaの「Threads」を利用していますが、Twitterに比べて非力

そのため、休眠する人が多い・・・

ここはやむなしでしょうが、もう少し、利便性Twitterが欲しい

いろいろ他のものを利用しても、結局、Twitterの利便性が目立つ

Twitterがどのような方向に向かうのかわかりませんが

現状のまま利用し、

Instagramや、ブログ、Threadsを並行して利用します

記録に残すものはブログ、つぶやきなどはブログ以外で利用します

Twitter、今後の方向性によっては、これに変わる存在のものが登場するかといえば、難しい

困ったことです

勉強をしない人が多い世の中

スマホなどがあれば情報を収集するのは簡単だし、勉強も容易になる

馬鹿なのかといえば馬鹿ではない

勉強のやり方と、情報を集める方法が知らないのが要因

簡単と思うかもしれないが、これは難しいのが実情

勉強もそうだが、やり方を間違うと、どんなに努力しても結果を得ることはない

スマホなどもそうだ、ゲームのやり方を知っていても、ゲーマにはなれない

すべて、やり方などを取得したものが、一流になれる

大企業に入るだけではなく、経営者は誰にでもなれるのだ

努力とは、やり方を知っているからできるのだ

エジソンは結果を出すために努力をしているのであって、すべてに努力をしているのではない

要は、これがと思うものを実用化しているだけです

それに特化している

努力とは、誰でもできるが、目的とするものは何かを考えずに行うから結果が出ない

結果を出すにはどうしたらよいのだろう

方向性を持って努力をするのだ

紫陽花

連携処理ができれば、いろいろな利点ができるのだが、

等で問題が多い

いうなれば、マイナカードを利用してだれが見たのかの情報をマイナカードの持ち主が見れることが必要です

誰が見たのかなどの情報を勝手に見たりしたものについては懲役を科すようにしてほしい

お友達関係の会社を排除してほしい

下記が典型的でミスが多い

大日本印刷は持続化などで多額の税金を得て、本人確認などで情報を取得している

そのため、現在多額のキャッシュフローが良い

もとは税金である・・・

下記2社をはやく倒産させよう

バラ、

ITを勉強する際、何事にも基本が第一

用語を知らなければ、何もできない

基本情報処理試験や応用技術者試験の本をまず読もう

さらにわからない用語は出てきますが、わからない用語は、後からでも調べればよいだけです

IT技術者として素質を考えると